如果我们可以使用数字水印保护视频,音频和照片,那为什么不使用AI模型呢?

这是我和我的同事在寻求开发一种技术以确保开发人员确保他们在构建AI(例如深度学习模型)方面的辛勤工作时可以受到保护的问题。您可能会想,“受什么保护?” 好吧,例如,如果您的AI 模型被盗用或滥用于恶意目的,例如提供基于被盗模型的pla窃服务,该怎么办?这是一个问题,特别是对于像IBM这样的AI领导者。

本月初,我们在大韩民国仁川举行的AsiaCCS '18大会上介绍了我们的研究,我们很自豪地说,我们为应对这一挑战而采用的综合评估技术被证明是高效而强大的。我们的主要创新在于,我们的概念可以使用简单的API查询来远程验证深度神经网络(DNN)服务的所有权。

随着深度学习模型的广泛部署和越来越有价值,对手越来越多地将其作为目标。我们的想法正在申请专利,它的灵感来自用于视频和照片等多媒体内容的流行水印技术。

给照片加水印时,有两个阶段:嵌入和检测。在嵌入阶段,所有者可以在照片(或人类可见的水印)上覆盖“ COPYRIGHT”一词,如果该照片被他人盗用并被他人使用,我们会在检测阶段进行确认,以便所有者可以提取水印作为法律依据证明所有权。相同的想法可以应用于DNN。

通过将水印嵌入DNN模型中(如果它们被盗),我们可以通过从模型中提取水印来验证所有权。但是,不同于将水印嵌入多媒体内容的数字水印,我们需要设计一种将水印嵌入DNN模型的新方法。

在本文中,我们描述了一种将水印注入DNN模型的方法,并设计了一种远程验证机制,以通过使用API调用来确定DNN模型的所有权。

我们开发了三种水印生成算法来为DNN模型生成不同类型的水印:

将有意义的内容与原始训练数据一起作为水印嵌入受保护的DNN中,

将不相关的数据样本作为水印嵌入受保护的DNN中,并且

将噪声作为水印嵌入受保护的DNN中。

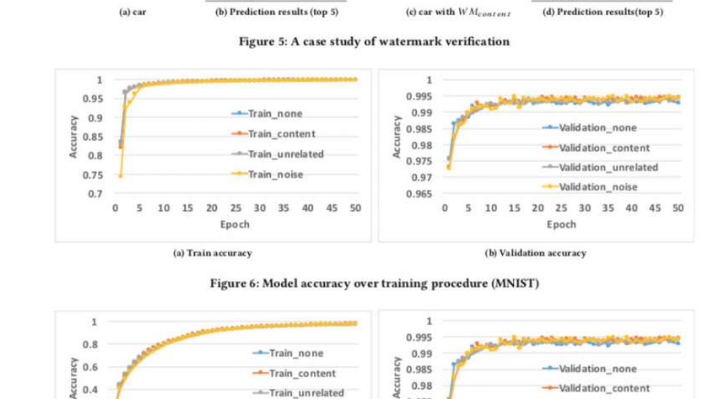

为了测试水印框架,我们使用了两个公共数据集:MNIST(手写数字识别数据集,具有60,000个训练图像和10,000个测试图像)和CIFAR10(具有50,000个训练图像和10,000个测试图像的对象分类数据集)。

运行实验非常简单:我们只需为DNN提供经过精心设计的图片,如果模型被加水印,就会触发意想不到但可控的响应。这不是第一次考虑加水印,但是以前的概念由于需要访问模型参数而受到限制。但是,在现实世界中,被盗模型通常是远程部署的,the窃的服务不会公开被盗模型的参数。此外,DNN模型中嵌入的水印对不同的反水印机制(例如微调,参数修剪和模型反演攻击)具有鲁棒性和弹性。

,,我们的框架确实有一些局限性。如果泄漏的模型未部署为在线服务而是用作内部服务,则我们将无法检测到任何盗窃,但是then窃者当然不能直接通过被盗模型获利。

此外,我们当前的水印框架无法保护DNN模型免于通过预测API被盗,从而攻击者可以利用查询访问和结果之间的机密性来学习机器学习模型的参数。但是,仅在具有较少模型参数(例如决策树和逻辑回归)的常规机器学习算法中,证明这种攻击在实践中可以很好地发挥作用。

我们目前正在寻求在IBM内部进行部署,并探索如何将该技术作为服务提供给客户。